在 TensorFlow.org 上查看 在 TensorFlow.org 上查看

|

在 Google Colab 中运行 在 Google Colab 中运行

|

在 GitHub 上查看源代码 在 GitHub 上查看源代码

|

下载笔记本 下载笔记本

|

TensorBoard 是 TensorFlow 中用于提供度量和可视化的内置工具。常见的机器学习实验指标,例如准确率和损失,可以在 TensorBoard 中跟踪和显示。TensorBoard 与 TensorFlow 1 和 2 代码兼容。

在 TensorFlow 1 中,tf.estimator.Estimator 默认情况下会为 TensorBoard 保存摘要。相比之下,在 TensorFlow 2 中,可以使用 tf.keras.callbacks.TensorBoard 回调 保存摘要。

本指南演示了如何使用 TensorBoard,首先是在 TensorFlow 1 中使用估计器,然后是如何在 TensorFlow 2 中执行等效过程。

设置

import tensorflow.compat.v1 as tf1

import tensorflow as tf

import tempfile

import numpy as np

import datetime

%load_ext tensorboard

mnist = tf.keras.datasets.mnist # The MNIST dataset.

(x_train, y_train),(x_test, y_test) = mnist.load_data()

x_train, x_test = x_train / 255.0, x_test / 255.0

TensorFlow 1:使用 tf.estimator 的 TensorBoard

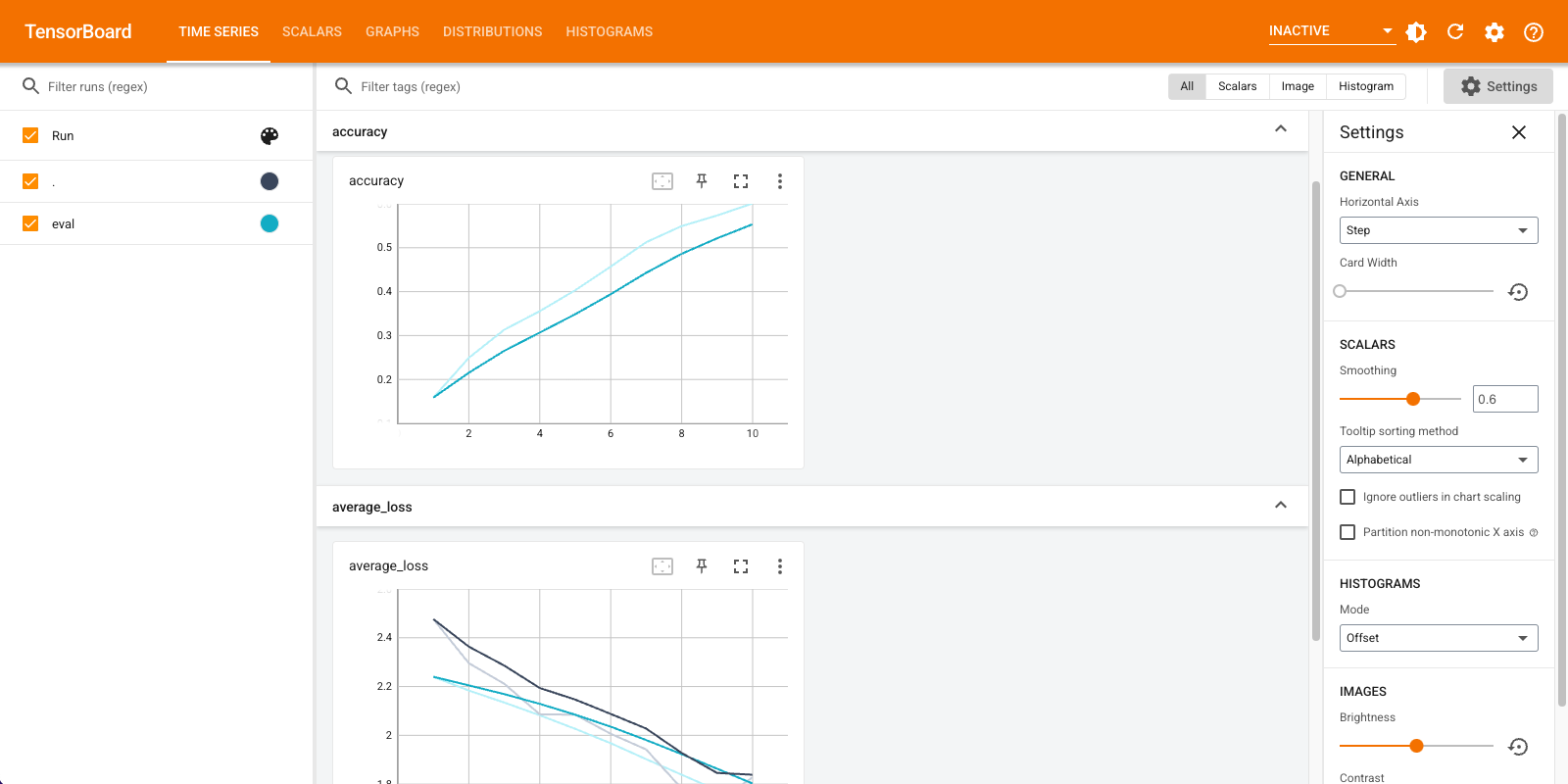

在本 TensorFlow 1 示例中,您将实例化一个 tf.estimator.DNNClassifier,在 MNIST 数据集上对其进行训练和评估,并使用 TensorBoard 显示指标

%reload_ext tensorboard

feature_columns = [tf1.feature_column.numeric_column("x", shape=[28, 28])]

config = tf1.estimator.RunConfig(save_summary_steps=1,

save_checkpoints_steps=1)

path = tempfile.mkdtemp()

classifier = tf1.estimator.DNNClassifier(

feature_columns=feature_columns,

hidden_units=[256, 32],

optimizer=tf1.train.AdamOptimizer(0.001),

n_classes=10,

dropout=0.1,

model_dir=path,

config = config

)

train_input_fn = tf1.estimator.inputs.numpy_input_fn(

x={"x": x_train},

y=y_train.astype(np.int32),

num_epochs=10,

batch_size=50,

shuffle=True,

)

test_input_fn = tf1.estimator.inputs.numpy_input_fn(

x={"x": x_test},

y=y_test.astype(np.int32),

num_epochs=10,

shuffle=False

)

train_spec = tf1.estimator.TrainSpec(input_fn=train_input_fn, max_steps=10)

eval_spec = tf1.estimator.EvalSpec(input_fn=test_input_fn,

steps=10,

throttle_secs=0)

tf1.estimator.train_and_evaluate(estimator=classifier,

train_spec=train_spec,

eval_spec=eval_spec)

%tensorboard --logdir {classifier.model_dir}

TensorFlow 2:使用 Keras 回调和 Model.fit 的 TensorBoard

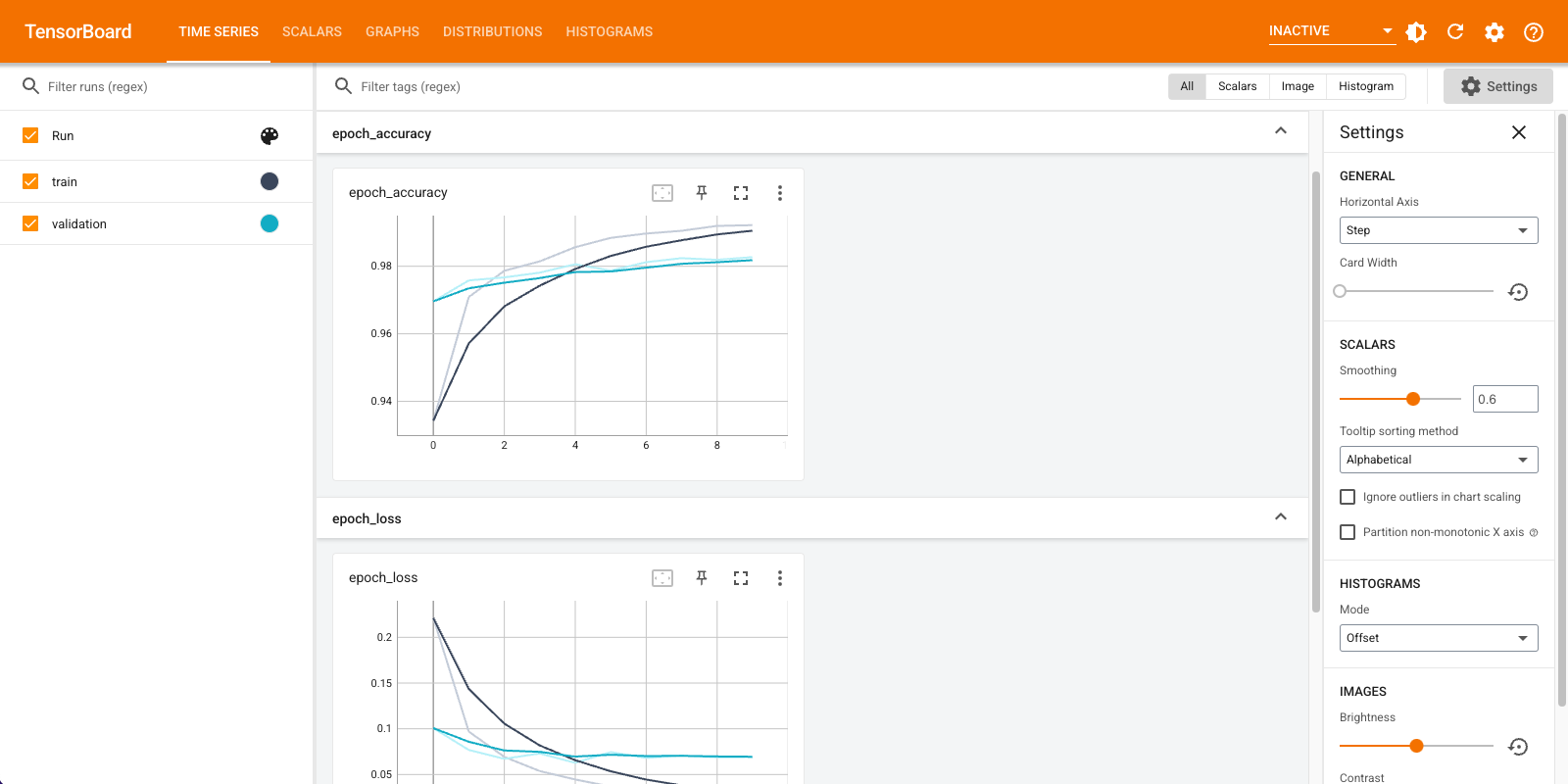

在本 TensorFlow 2 示例中,您将使用 tf.keras.callbacks.TensorBoard 回调创建和存储日志,并训练模型。回调会跟踪每个纪元的准确率和损失。它在 callbacks 列表中传递给 Model.fit。

%reload_ext tensorboard

def create_model():

return tf.keras.models.Sequential([

tf.keras.layers.Flatten(input_shape=(28, 28), name='layers_flatten'),

tf.keras.layers.Dense(512, activation='relu', name='layers_dense'),

tf.keras.layers.Dropout(0.2, name='layers_dropout'),

tf.keras.layers.Dense(10, activation='softmax', name='layers_dense_2')

])

model = create_model()

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'],

steps_per_execution=10)

log_dir = tempfile.mkdtemp()

tensorboard_callback = tf.keras.callbacks.TensorBoard(

log_dir=log_dir,

histogram_freq=1) # Enable histogram computation with each epoch.

model.fit(x=x_train,

y=y_train,

epochs=10,

validation_data=(x_test, y_test),

callbacks=[tensorboard_callback])

%tensorboard --logdir {tensorboard_callback.log_dir}

后续步骤

- 在 入门 指南中了解有关 TensorBoard 的更多信息。

- 对于更低级的 API,请参阅 tf.summary 迁移到 TensorFlow 2 指南。